在autodl上通过ollama的一键安装脚本进行安装:curl -fsSL https://ollama.com/install.sh | sh,紧接着想要更改ollama下载的模型位置。

但autodl的容器并不支持systemctl管理,而且在~/.bashrc中设置OLLAMA_MODELS环境变量后,发现ollama serve启动时显示的模型下载位置依旧是原来的~/.ollama目录。

有两种解决思路:

# 启动ollama时,指定模型存放位置

OLLAMA_MODELS="/root/autodl-tmp/ollama" ollama serve

# 在执行一键脚本之前就先把环境变量设置好,这样子一键脚本安装的ollama模型位置就是期待的目录

export OLLAMA_MODELS="/root/autodl-tmp/ollama"

curl -fsSL https://ollama.com/install.sh | sh

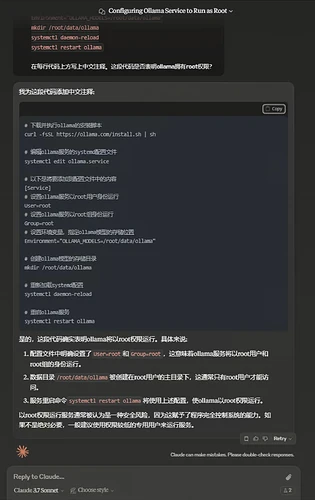

彗星云平台支持systemctl管理ollama服务。但在一键脚本安装过后设置OLLAMA_MODELS环境变量并不生效。

一键脚本安装后,在该平台设置ollama模型下载位置的方式如下:

# 下载并执行ollama的安装脚本

curl -fsSL https://ollama.com/install.sh | sh

# 编辑ollama服务的systemd配置文件

systemctl edit ollama.service

# 以下是将要添加到配置文件中的内容

[Service]

# 设置ollama服务以root用户身份运行

User=root

# 设置ollama服务以root组身份运行

Group=root

# 设置环境变量,指定ollama模型的存储位置

Environment="OLLAMA_MODELS=/root/data/ollama"

# 创建ollama模型的存储目录

mkdir /root/data/ollama

# 重新加载systemd配置

systemctl daemon-reload

# 重启ollama服务

systemctl restart ollama

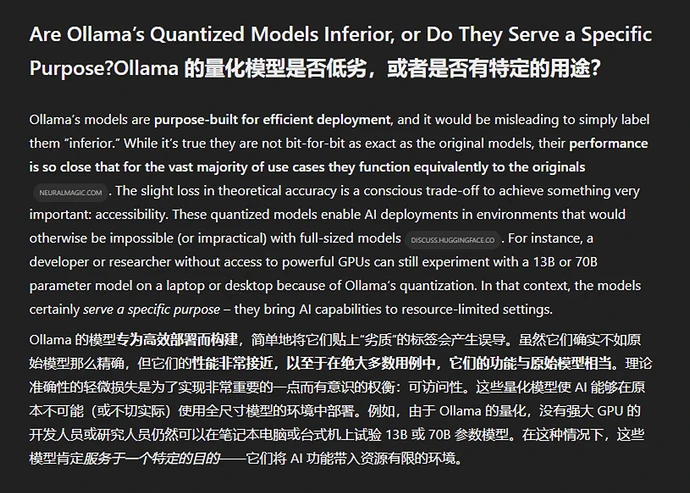

ollama中的模型是否是劣质模型,OpenAI Deep Researcher的回答: