1、 基于大模型和 RAG 的知识库问答系统—maxkb:https://maxkb.cn

2、chatwiki:GitHub - zhimaAi/chatwiki: 开箱即用的基于企业私有知识库的LLM大语言模型的智能客服机器人问答系统,支持私有化部署,代码免费开源且可商用,由芝麻小客服官方推出。

还有一些如

-

cherry studio的知识库等一些项目

-

一些低代码构建ai应用项目dify、coze等

-

成熟的产品:如google notebooklm等

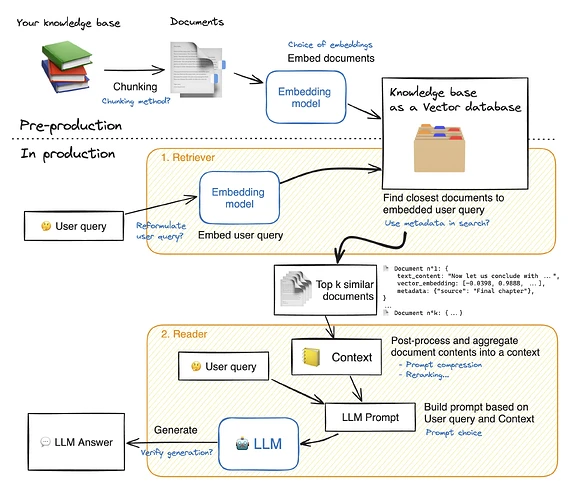

去年年底按照huggingface教程指出的RAG流程中可以增强的点,水了3篇论文。

一篇待出版检索,一篇待参会,一篇等待结果,希望结果好一些。

毕业要求:发表一篇省级以上的刊物,达到了毕业要求,就只需水毕业论文了,水完毕业论文,我这辈子再也不碰论文,学术不适合我。

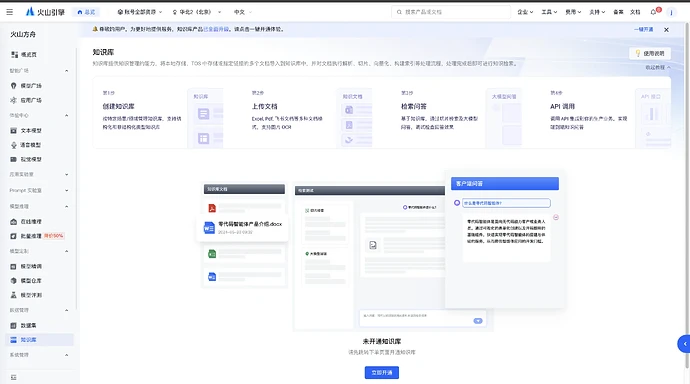

国产的纳米AI搜索/智谱清言等据说也支持知识库,以此来进行问答。

基于RAG的开源文档聊天工具:GitHub - Cinnamon/kotaemon: An open-source RAG-based tool for chatting with your documents.

开箱即用的基于企业私有知识库的LLM大语言模型的智能客服机器人问答系统: GitHub - zhimaAi/chatwiki: 开箱即用的基于企业私有知识库的LLM大语言模型的智能客服机器人问答系统,支持私有化部署,代码免费开源且可商用,由芝麻小客服官方推出。